Operativně analytické zpracování olapových dat. Operativně analytické zpracování dat. Požadavky na online nástroje analytického zpracování

(DBMS. - 1998. - č. 4-5)

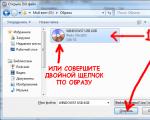

Současná úroveň vývoje hardwaru a softwaru již nějakou dobu umožňuje udržovat rozsáhlé databáze provozní informace na všech úrovních řízení. Průmyslové podniky, korporace, resortní struktury, státní úřady a řídící orgány nashromáždily v průběhu své činnosti velké objemy dat. Obsahují velký potenciál pro extrakci užitečného analytické informace, na jejichž základě je možné identifikovat skryté trendy, budovat strategii rozvoje a nacházet nová řešení.

V posledních letech Ve světě se zformovala řada nových konceptů pro ukládání a analýzu podnikových dat:

Tento článek je věnován přehledu těchto konceptů a také důkazu jejich komplementarity při podpoře rozhodování managementu.

1. Datové sklady

V oblasti informačních technologií vždy vedle sebe existovaly dvě třídy systémů [, s. 49]:

V prvních fázích informatizace je vždy nutné nastolit pořádek právě v procesech každodenního rutinního zpracování dat, na což jsou zaměřeny tradiční SOD, takže rychlý rozvoj této třídy systémů je vcelku pochopitelný.

Systémy druhé třídy - DSS - jsou ve vztahu k nim druhotné. Často nastává situace, kdy se data v organizaci shromažďují z řady nesouvisejících systémů pro ukládání dat, které se do značné míry vzájemně duplikují, ale nejsou jakkoli koordinovány. V tomto případě je téměř nemožné získat spolehlivé komplexní informace, a to i přes jejich zdánlivou hojnost.

Účelem budování podnikového datového skladu je integrovat, aktualizovat a harmonizovat provozní data z různých zdrojů a vytvořit tak jednotný konzistentní pohled na objekt správy jako celku. Koncepce datových skladů přitom vychází z uznání potřeby oddělit datové sady používané pro transakční zpracování a datové sady používané v systémech pro podporu rozhodování. Takové oddělení je možné integrací podrobných dat oddělených v ODS a externích zdrojů do jednoho úložiště, jejich koordinací a případně agregací. W. Inmon, autor konceptu datových skladů, takové sklady definuje jako:

- "oborově zaměřená,

- integrovaný,

- neměnný,

- podpůrná chronologie

datové soubory organizované na podporu managementu“ navržené tak, aby fungovaly jako „jediný zdroj pravdy“, který poskytuje manažerům a analytikům spolehlivé informace potřebné pro operativní analýzu a podporu rozhodování.

Koncept datového skladu není jen o jediném logickém pohledu na data organizace, ale o skutečné implementaci jediného integrovaného zdroje dat. Alternativou k tomuto konceptu, cestou k vytvoření jednotného pohledu na firemní data, je vytvoření virtuálního zdroje založeného na distribuovaných databázích různých ODS. Navíc je každý požadavek na takový zdroj dynamicky překládán do požadavků do zdrojových databází a získané výsledky jsou koordinovány, propojeny, agregovány a vráceny uživateli za běhu. Navzdory své vnější eleganci má však tato metoda řadu významných nevýhod.

- Doba zpracování požadavků na distribuované úložiště výrazně překračuje odpovídající ukazatele pro centralizované úložiště. Databázové struktury ODS určené pro intenzivní aktualizaci jednotlivých záznamů jsou navíc vysoce normalizované, takže analytický dotaz proti nim vyžaduje spojení velkého počtu tabulek, což také vede ke snížení výkonu.

- Integrovaný pohled na distribuované podnikové úložiště je možný pouze v případě, že jsou všechny zdroje dat v síti vždy připojeny. Dočasná nedostupnost alespoň jednoho ze zdrojů tak může buď znemožnit provoz informačního a analytického systému (IAS), nebo vést k chybným výsledkům.

- Provádění složitých analytických dotazů na tabulky ODS spotřebovává velké množství prostředků databázového serveru a vede ke snížení výkonu ODS, což je nepřijatelné, protože doba provádění operací v ODS je často velmi kritická.

- Různé ODS mohou podporovat různé datové formáty a kódování a data v nich mohou být nekonzistentní. Velmi často může být na stejnou otázku obdrženo několik možností odpovědi, což může být způsobeno nesynchronizací momentů aktualizace dat, rozdíly v interpretaci jednotlivých událostí, konceptů a dat, změnami v sémantice dat v procesu vývoje předmětová oblast, vstupní chyby, ztráta archivů fragmentů atd. V tomto případě nemusí být dosaženo cíle - vytvoření jediného konzistentního pohledu na objekt správy.

- Za hlavní nevýhodu je třeba uznat praktickou nemožnost revize dlouhodobých historických sekvencí, protože při fyzické absenci centrálního úložiště jsou k dispozici pouze ta data, která jsou v době žádosti v reálných databázích souvisejících ODS. Hlavním účelem ODS je operativní zpracování dat, takže nemají luxus ukládat data po dlouhou dobu (více než několik měsíců); Jakmile se data stanou zastaralými, jsou nahrána do archivu a odstraněna z transakční databáze. Z hlediska analytického zpracování je to právě nejzajímavější pohled na objekt řízení v historickém retrospektivě.

Datový sklad tedy funguje podle následujícího scénáře. Dle daných předpisů shromažďuje data z různých zdrojů – systémových databází operativní zpracování. Úložiště podporuje chronologii: spolu s aktuálními daty se ukládají historická data s uvedením času, ke kterému se vztahují. V důsledku toho jsou potřebná dostupná data o řídicím objektu shromážděna na jednom místě, převedena do jediného formátu, koordinována a v některých případech agregována na minimální požadovanou úroveň zobecnění.

Odlehčenou verzí podnikového datového skladu mohou být datové tržiště ( Data Mart), tedy tematické databáze obsahující informace týkající se jednotlivých aspektů činnosti organizace. Koncept datových trhů byl představen společností Forrester Research v roce 1991. Hlavní myšlenkou bylo, že datové tržiště obsahují tematické podmnožiny předem agregovaných dat, které jsou mnohem menší než celopodnikové datové sklady, a proto vyžadují méně produktivní technologii pro údržbu. V roce 1994 navrhl M. Demarest kombinaci těchto dvou konceptů a použití datového skladu jako jediného integrovaného zdroje pro více datových trhů. V této verzi má podnikový informační a analytický systém tříúrovňovou strukturu:

- celopodnikový centralizovaný datový sklad;

- tematické data markety na úrovni oddělení;

- pracovní stanice koncových uživatelů vybavené analytickými nástroji.

Uvažovaný koncept je zaměřen výhradně na ukládání, nikoli na zpracování firemních dat. Nepředurčuje architekturu cílových analytických systémů, ale pouze vytváří pole působnosti pro jejich fungování se zaměřením na datové požadavky. Ponechává tedy svobodu volby ve všem, co se týká:

- způsoby reprezentace dat v cílovém úložišti (například relační, vícerozměrné);

- režimy analýzy dat úložiště.

2. Metody analytického zpracování dat

Aby stávající datové sklady usnadnily rozhodování managementu, musí být informace analytikovi předloženy v požadované podobě, to znamená, že musí mít vyvinuté nástroje pro přístup a zpracování dat skladu.

Podle kritéria režimu analýzy dat se informační a analytické systémy dělí do dvou kategorií [, ]:

- statické (včetně předem definované sady scénářů zpracování dat a hlášení); Do této kategorie patří tzv. výkonné informační systémy (MIS);

- dynamický (podporuje konstrukci a provádění ad hoc dotazů a generování sestav ve volném formátu).

Velmi často se ukazuje, že informační systémy vytvořené s očekáváním přímého použití osobami s rozhodovací pravomocí jsou extrémně snadno použitelné, ale mají výrazně omezenou funkčnost. Takové statické DSS [, str. 55] nebo Executive Information Systems (IIS) [, str. 73] - (Executive Information Systems, EIS) [, str. 4] - obsahují předdefinované sady dotazů a jsou dostatečné pro každodenní kontrolu , nejsou schopni zodpovědět všechny otázky o dostupných datech, které mohou při rozhodování vyvstat (POZNÁMKA: Podle definice V. Przyjalkowského [, S. 81] je ISR „počítačový systém, který umožňuje ... poskytovat informace na disponování vedoucími pracovníky s omezenými zkušenostmi s počítači."). Výsledkem takového systému jsou zpravidla vícestránkové zprávy, po jejichž pečlivém prostudování má analytik novou řadu otázek; každý nový požadavek, s nímž se při návrhu takového systému nepočítalo, však musí být nejprve formálně popsán, předán programátorovi, zakódován a teprve poté proveden. Čekací doba v tomto případě může být hodiny a dny, což není vždy přijatelné. Externí jednoduchost statických DSS, za kterou většina zákazníků informačních a analytických systémů aktivně bojuje, se tak mění v katastrofální ztrátu flexibility.

Dynamické DSS se naopak zaměřují na zpracování neregulovaných, neočekávaných (ad hoc) požadavků analytiků na data. Požadavky na takové systémy se nejhlouběji zabýval E. F. Codd v článku, který položil základy konceptu OLAP. Práce analytiků s těmito systémy sestává z interaktivní sekvence generování dotazů a studia jejich výsledků, z nichž každý může vyvolat potřebu nové řady dotazů.

Dynamické DSS však mohou fungovat nejen v oblasti online analytického zpracování (OLAP); podporu pro rozhodování managementu na základě nashromážděných dat lze provádět ve třech základních oblastech.

Podle Codda je vícerozměrný koncepční pohled nejpřirozenějším pohledem řídících pracovníků na objekt řízení. Představuje vícenásobnou perspektivu skládající se z několika nezávislých dimenzí, podle nichž lze analyzovat konkrétní soubory dat. Simultánní analýza podél více dimenzí dat je definována jako multivariační analýza. Každá dimenze zahrnuje oblasti konsolidace dat sestávající z řady po sobě jdoucích úrovní zobecnění, kde každá vyšší úroveň odpovídá většímu stupni agregace dat pro odpovídající dimenzi. Dimenze Performer tedy může být určena směrem konsolidace, skládající se z úrovní zobecnění „podnik – divize – oddělení – zaměstnanec“. Dimenze Čas může dokonce zahrnovat dva směry konsolidace – „rok – čtvrtletí – měsíc – den“ a „týden – den“, protože počítání času po měsících a týdnech není kompatibilní. V tomto případě je možné libovolně vybrat požadovanou úroveň podrobností informací pro každý z rozměrů. Operace vrtání odpovídá pohybu z vyšších do nižších stupňů konsolidace; naopak rolovací operace znamená pohyb z nižších do vyšších úrovní (obr. 2).

Rýže. 2. Dimenze a směry konsolidace dat.

3.1. Požadavky na online nástroje analytického zpracování

Codd identifikoval 12 pravidel, která musí splňovat softwarový produkt třídy OLAP (tabulka 1).

Tabulka 1. Pravidla hodnocení softwarových produktů třída OLAP.

| 1. | Vícerozměrný koncepční pohled | Koncepční reprezentace datového modelu v produktu OLAP by měla být multidimenzionální povahy, to znamená, aby analytikům umožňovala provádět intuitivní operace „slice and dice“ (překlad S. D. Kuznetsova, projev na 3. výroční konferenci „Firemní databáze „98“) , rotace (rotace) a umístění (pivot) směrů konsolidace. |

|---|---|---|

| 2. | Průhlednost | Uživatel nemusí vědět, jaké konkrétní nástroje se používají k ukládání a zpracování dat, jak jsou data organizována a odkud pocházejí. |

| 3. | Přístupnost | Analytik musí být schopen provádět analýzu v rámci společného koncepčního rámce, ale data mohou zůstat pod kontrolou starších DBMS, zatímco jsou vázána na společný analytický model. To znamená, že nástroj OLAP musí překrývat své logické schéma na fyzických sadách dat a provádět všechny transformace potřebné k poskytnutí jediného, konzistentního a holistického pohledu na informace uživatele. |

| 4. | Konzistentní výkon přehledů | S rostoucím počtem dimenzí a velikostí databáze by analytici neměli zaznamenat žádné snížení výkonu. Trvalý výkon je nezbytný pro zachování snadného použití a osvobození od složitosti, která je nutná k tomu, aby se OLAP dostal ke koncovému uživateli. |

| 5. | Architektura klient-server | Většina dat, která vyžadují rychlé analytické zpracování, je uložena v systémech sálových počítačů a načítána z nich osobní počítače. Jedním z požadavků je proto schopnost produktů OLAP pracovat v prostředí klient-server. Hlavní myšlenkou je, že serverová součást nástroje OLAP musí být dostatečně inteligentní a musí mít schopnost vytvořit společné koncepční schéma shrnutím a konsolidací různých logických a fyzických schémat podnikových databází, aby byl zajištěn transparentní efekt. |

| 6. | Obecná dimenzionalita | Všechny datové dimenze musí být stejné. Jednotlivým rozměrům lze poskytnout další funkce, ale protože jsou všechny symetrické, lze tuto dodatečnou funkčnost poskytnout libovolnému rozměru. Základní datová struktura, vzorce a formáty výkazů by se neměly spoléhat na žádný jeden rozměr. |

| 7. | Dynamická manipulace s řídkou maticí | Nástroj OLAP musí poskytovat optimální zpracovánířídké matrice. Rychlost přístupu musí být zachována bez ohledu na umístění datových buněk a musí být konstantní hodnotou pro modely s jiné číslo měření a různé řídkosti dat. |

| 8. | Podpora více uživatelů | Často musí několik analytiků pracovat současně s jedním analytickým modelem nebo vytvářet různé modely založené na stejných podnikových datech. Nástroj OLAP jim musí poskytnout souběžný přístup a zajistit integritu a bezpečnost dat. |

| 9. | Neomezená podpora mezidimenzionálních operací | Výpočty a manipulace s daty v libovolném počtu dimenzí nesmí zakazovat ani omezovat žádné vztahy mezi datovými buňkami. Transformace, které vyžadují libovolnou definici, musí být specifikovány ve funkčně úplném vzorcovém jazyce. |

| 10. | Intuitivní manipulace s daty | Změna orientace směrů konsolidace, detailování dat ve sloupcích a řádcích, agregace a další manipulace vlastní struktuře hierarchie směrů konsolidace by měly být prováděny v nejpohodlnějším, nejpřirozenějším a nejpohodlnějším uživatelském rozhraní. |

| 11. | Flexibilní mechanismus podávání zpráv | Musí být podporovány různé způsoby vizualizace dat, to znamená, že zprávy musí být prezentovány v jakékoli možné orientaci. |

| 12. | Neomezené dimenze a úrovně agregace | Důrazně se doporučuje, aby každý seriózní nástroj OLAP předpokládal v analytickém modelu alespoň patnáct, nejlépe dvacet rozměrů. Každá z těchto dimenzí by navíc měla umožňovat prakticky neomezený počet uživatelem definovaných úrovní agregace v jakémkoli směru konsolidace. |

Soubor těchto požadavků, který sloužil jako skutečná definice OLAP, byl poměrně často kritizován. Říká se, že v rámci 12 požadavků se mísí následující:

- skutečné požadavky na funkčnost (1, 2, 3, 6, 9, 12);

- neformalizovaná přání (4, 7, 10, 11);

- požadavky na architekturu informačního systému, které mají velmi hrubý vztah k funkčnosti (5, 8); například podle požadavku 5 systém implementovaný na bázi serveru UNIX s terminály nemůže být produktem OLAP, protože nefunguje v architektuře klient-server; Produkt OLAP také nemůže být stolním systémem pro jednoho uživatele, protože v tomto případě je porušen požadavek 8.

Na druhou stranu, podle samotného Codda, žádný z produktů pro analýzu provozních dat, které jsou v současnosti na trhu k dispozici, plně nesplňuje všechny jím předložené požadavky. Těchto 12 pravidel by proto mělo být považováno za doporučení a konkrétní produkty by měly být posuzovány podle stupně přiblížení k ideální plné shodě se všemi požadavky.

3.2. Klasifikace produktů OLAP podle metody prezentace dat

V současné době je na trhu asi 30 produktů, které v té či oné míře poskytují funkcionalitu OLAP (podle webového serveru s přehledem http://www.olapreport.com z února 1998). Všechny produkty OLAP poskytují vícerozměrný koncepční pohled z uživatelského rozhraní na zdrojovou databázi a jsou rozděleny do tří tříd podle typu zdrojové databáze.

Kromě uvedených nástrojů existuje další třída - nástroje pro generování dotazů a sestav pro stolní PC, doplněné o funkce OLAP a/nebo integrované s externími nástroji, které takové funkce provádějí. Tyto poměrně pokročilé systémy získávají data ze zdrojových zdrojů, transformují je a umísťují do dynamické vícerozměrné databáze fungující na klientské stanici koncového uživatele. Tyto nástroje jsou nejvhodnější pro práci s malými, jednoduše organizovanými databázemi. Hlavními představiteli této třídy jsou BusinessObjects od stejnojmenné společnosti BrioQuery od Brio Technology [, str. 34] a PowerPlay od společnosti Cognos [, str. 34-35].

3.2.1. Multidimenzionální OLAP (MOLAP)

Ve specializovaných DBMS založených na vícerozměrné reprezentaci dat nejsou data organizována ve formě relační tabulky a ve formě uspořádaných vícerozměrných polí:

- hyperkrychle (všechny buňky uložené v databázi musí mít stejný rozměr, to znamená být v nejúplnější základně měření) nebo

- polycubes (každá proměnná je uložena s vlastní sadou dimenzí a všechny související složitosti zpracování jsou přeneseny do vnitřních mechanismů systému).

Použití vícerozměrných databází v online systémech analytického zpracování má následující výhody.

Na druhou stranu jsou zde značná omezení.

V důsledku toho je použití vícerozměrné DBMS oprávněné pouze za následujících podmínek.

- Objem zdrojových dat pro analýzu není příliš velký (ne více než několik gigabajtů), to znamená, že úroveň agregace dat je poměrně vysoká.

- Sada informačních dimenzí je stabilní (protože jakákoliv změna jejich struktury téměř vždy vyžaduje kompletní restrukturalizaci hyperkrychle).

- Doba odezvy systému na neregulované požadavky je nejkritičtějším parametrem.

- Vyžaduje rozsáhlé používání složitých vestavěných funkcí k provádění mezirozměrných výpočtů na buňkách hyperkrychle, včetně schopnosti psát vlastní funkce.

3.2.2. Relační OLAP (ROLAP)

Přímé použití relačních databází jako zdrojových dat v online systémech analytického zpracování má následující výhody.

- Při operativním analytickém zpracování obsahu datových skladů umožňují nástroje ROLAP provádět analýzy přímo na skladu (protože podnikové datové sklady jsou v naprosté většině případů implementovány pomocí relačních DBMS).

- V případě problému proměnných rozměrů, kdy je nutné poměrně často provádět změny ve struktuře měření, jsou optimálním řešením systémy ROLAP s dynamickou reprezentací rozměrů, protože takové úpravy nevyžadují fyzickou reorganizaci databáze.

- Systémy ROLAP mohou pracovat na mnohem méně výkonných klientských stanicích než systémy MOLAP, protože hlavní výpočetní zátěž v nich spočívá na serveru, kde jsou prováděny komplexní analytické SQL dotazy generované systémem.

- Relační DBMS poskytují výrazně vyšší úroveň ochrany dat a přístupových práv.

- Relační DBMS mají skutečné zkušenosti s prací s velmi rozsáhlými databázemi a vyvinutými nástroji pro správu.

Nevýhody systémů ROLAP již byly diskutovány při výčtu výhod použití vícerozměrných databází. Toto je za prvé, omezené příležitosti z pohledu výpočtu hodnot funkčního typu a za druhé - nižší výkon. Aby byl zajištěn výkon srovnatelný s MOLAP, relační systémy vyžadují pečlivý návrh schématu databáze a speciální nastavení indexy. Ale v důsledku těchto operací je výkon dobře vyladěných relačních systémů využívajících hvězdicové schéma zcela srovnatelný s výkonem systémů založených na vícerozměrných databázích.

Práce [, ,] jsou celé věnovány popisu hvězdného schématu a doporučením pro jeho použití. Myšlenka je taková, že pro každou dimenzi existují tabulky a všechna fakta jsou umístěna v jedné tabulce, indexované vícenásobným klíčem složeným z klíčů jednotlivých dimenzí. Každý paprsek hvězdného diagramu určuje, v Coddově terminologii, směr konsolidace dat podél příslušné dimenze (například Prodejna – Město/Obvod – Oblast).

Obecně mají fakta různé sady rozměrů a pak je vhodné je ukládat nikoli do jedné, ale do několika tabulek; Navíc v různých dotazech může uživatele zajímat pouze část možných rozměrů. Ale s tímto přístupem, kdy existuje velký počet nezávislých dimenzí, je nutné udržovat mnoho tabulek faktů odpovídajících každé možné kombinaci dimenzí vybraných v dotazu, což vede k plýtvání externí paměť, delší čas pro načítání dat do databáze hvězdných schémat z externích zdrojů a potíže s administrací. K vyřešení tohoto problému autoři práce navrhují speciální rozšíření pro jazyk SQL (operátor "GROUP BY CUBE" a klíčové slovo "ALL") (POZNÁMKA: V současné době toto rozšíření ještě nebylo přijato, takže toto návrh je zatím čistě akademický.) a autoři [,] doporučují vytvářet tabulky faktů ne pro všechny možné kombinace dimenzí, ale pouze pro ty nejúplnější (ty, jejichž hodnoty buněk nelze získat následnou agregací buněk jiných tabulek faktů v databázi).

Ve složitých problémech s víceúrovňovými měřeními má smysl obrátit se na rozšíření hvězdného schématu - schéma souhvězdí (fact constellation schema) [, s. 10-11] a schéma sněhové vločky [, s. 13-15]. V těchto případech jsou vytvořeny samostatné tabulky faktů pro možné kombinace souhrnných úrovní různých dimenzí. To umožňuje nejlepší výkon, ale často vede k redundanci dat.

V každém případě, pokud je multidimenzionální model implementován jako relační databáze, měli byste vytvořit dlouhé a „úzké“ tabulky faktů a relativně malé a „široké“ tabulky dimenzí. Tabulky faktů obsahují číselné hodnoty buněk hyperkrychle a zbývající tabulky definují vícerozměrnou základnu měření, která je obsahuje.

Zaměření na reprezentaci vícerozměrných informací pomocí relačních modelů ve tvaru hvězdy nám umožňuje zbavit se problému s optimalizací ukládání řídkých matic, který je akutní pro vícerozměrné DBMS (kde je problém řídkosti řešen speciální volbou schématu). Přestože se k uložení každé buňky v tabulce faktů používá celý záznam (která kromě hodnot samotných obsahuje sekundární klíče - odkazy na tabulky dimenzí), neexistující hodnoty nemusí být zahrnuty do faktu. tabulka, to znamená, že přítomnost prázdných buněk v databázi je vyloučena. Indexování zajišťuje přijatelnou rychlost přístupu k datům v tabulkách faktů.

4. Data mining

Sféra vzorů se od předchozích dvou liší tím, že se v ní nashromážděné informace automaticky zobecňují na informace, které lze charakterizovat jako znalosti. Tento proces je nyní pro uživatele mimořádně relevantní a jeho význam bude časem jen růst, protože podle zákona uvedeného v „se množství informací ve světě zdvojnásobí každých 20 měsíců“, zatímco „ výpočetní technika", který sliboval studnici moudrosti, zatím pouze reguluje tok dat."

Data mining je ve většině publikací definován aforisticky – „extrahování zrnek znalostí z hor dat“, „dolování dat – analogicky s rozvojem nerostných zdrojů“. Navíc v angličtině existují dva pojmy přeložené jako IAD - Knowledge Discovery in Databases (KDD) a Data Mining (DM). Ve většině prací jsou používány jako synonyma [viz např. ], ačkoli někteří autoři [ , ] považují KDD za širší pojem – vědecký směr vzniklý „na průsečíku umělé inteligence, statistiky a teorie databází“ a poskytující proces extrakce informací z dat a jejich využití a DM - jako soubor induktivních metod tohoto procesu, tedy to, co bude dále definováno jako fáze vyhledávání zdarma IAD.

Zastavme se u následující definice: IAD je proces podpory rozhodování založený na hledání skrytých vzorců (informačních vzorů) v datech [,]. Je třeba poznamenat, že většina metod IDA byla původně vyvinuta v rámci teorie umělé inteligence (AI) v 70-80 letech, ale rozšířila se až v posledních letech, kdy problém intelektualizace zpracování velkých a rychle rostoucích objemů firemních dat vyžadovalo jejich použití jako doplňků pro datové sklady.

4.2.2. Prediktivní modelování

Zde, ve druhé fázi IAD, se používají plody práce první, to znamená, že vzory nalezené v databázi se používají k předpovídání neznámých hodnot:

- při klasifikaci nového objektu jej můžeme s jistou jistotou přiřadit k určité skupině výsledků z uvažování známých hodnot jeho atributů;

- Při predikci dynamického procesu lze výsledky určování trendu a periodických fluktuací použít k vytvoření předpokladů o pravděpodobném vývoji nějakého dynamického procesu v budoucnu.

Vraťme se k diskutovaným příkladům a pokračujme v nich do této fáze. Když víte, že někdo Ivanov je programátor, můžete si být 61% jisti, že jeho věk

Je třeba poznamenat, že bezplatné vyhledávání odhaluje obecné vzorce, tj. je induktivní, zatímco jakákoli předpověď odhaduje hodnoty konkrétních neznámých veličin, proto je deduktivní. Výsledné struktury mohou být navíc buď průhledné, tedy umožňující rozumnou interpretaci (jako v příkladu s vygenerovanými logickými pravidly), nebo neinterpretovatelné – „černé skříňky“ (nikdo například přesně neví, jak sestavit a trénovat neurální síť, která přesně funguje).

4.2.3. Analýza výjimek (Forenzní analýza)

Předmětem této analýzy jsou anomálie v odhalených vzorcích, tedy nevysvětlitelné výjimky. Chcete-li je najít, musíte nejprve určit normu (fáze bezplatného vyhledávání) a poté identifikovat její porušení. Po zjištění, že 84 % středních škol je klasifikováno jako obecní formulář 16%, které tvoří výjimku z tohoto pravidla? Možná pro ně existuje logické vysvětlení, které lze také formalizovat ve formě vzoru. Může se ale také stát, že máme co do činění s chybami ve zdrojových datech, v takovém případě lze analýzu výjimek použít jako nástroj pro vyčištění informací v datovém skladu.

4.3. Klasifikace technologických metod IAD

Všechny metody IDA jsou rozděleny do dvou velkých skupin na základě principu práce s daty vstupního tréninku.

- V prvním případě mohou být zdrojová data uložena v explicitní granulární formě a přímo použita pro prediktivní modelování a/nebo analýzu výjimek; Jedná se o takzvané metody usuzování založené na případové analýze. Hlavním problémem této skupiny metod je obtížnost jejich použití na velkých objemech dat, i když právě při analýze velkých datových skladů přinášejí metody IDA největší přínos.

- Ve druhém případě se informace nejprve extrahují z primárních dat a transformují se do nějakých formálních struktur (jejich typ závisí na konkrétní metodě). Podle předchozí klasifikace se tato fáze provádí ve fázi volného vyhledávání, která v metodách první skupiny v podstatě chybí. Pro prediktivní modelování a analýzu výjimek se tedy používají výsledky této fáze, které jsou mnohem kompaktnější než samotná pole zdrojových dat. V tomto případě mohou být výsledné konstrukce buď „transparentní“ (interpretovatelné) nebo „černé skříňky“ (neinterpretovatelné).

Tyto dvě skupiny a metody v nich zahrnuté jsou uvedeny na Obr. 4.

Rýže. 4. Klasifikace technologických metod IAD.

4.3.1. Přímé využití tréninkových dat

Zobecněný algoritmus Lazy-Learning, který patří do uvažované skupiny, vypadá takto (popis algoritmu je převzat z). Na vstup klasifikátoru je uveden příklad a na výstupu se očekává předpověď třídy, která jej obsahuje. Každý příklad je reprezentován bodem ve vícerozměrném prostoru vlastností (atributů), patřících do určité třídy. Každý atribut přijímá buď spojité hodnoty, nebo diskrétní hodnoty z pevné sady. Například je vrácena jeho nejpravděpodobnější třída.

Samostatnou vlastností algoritmu k-nejbližšího souseda je metoda pro určení zadní pravděpodobnosti příkladu patřícího do třídy:

kde vrátí 1, když jsou argumenty stejné, nebo 0 jinak, je funkce přiblížení definovaná jako

a je množina k nejbližších sousedů v množině známých trénovacích příkladů, jejichž blízkost ke klasifikovanému příkladu je určena funkcí vzdálenosti. Metoda k-nejbližšího souseda vypočítá vzdálenost od každého pomocí vzorce:

navíc se nejčastěji předpokládá r=2 (euklidovský prostor) a funkce je v závislosti na typu atributu definována takto:

w(f) je funkcí váhy atributu f. V čistém algoritmu k-nejbližšího souseda:

to znamená, že tato funkce je považována za konstantu.

Metoda nejbližšího souseda je speciální případ metody k-nejbližšího souseda s k=1. Složitější algoritmy, jako je Lazy-Learning, jsou založeny na stejném zobecněném algoritmu [ , , ], ale buď jinak určují pozdější pravděpodobnosti příkladů patřících do tříd, nebo (jako například Nested Generalized Exemplars Algoritm) komplikují výpočet funkce w(f).

Zvláštností této skupiny metod je, že predikce neznámých hodnot se provádí na základě explicitního porovnání nového objektu (příkladu) s slavné příklady. V případě velkého počtu tréninkových příkladů, aby nedošlo k postupnému skenování celého tréninkového souboru pro klasifikaci každého nového příkladu, se někdy používá technika vzorkování relativně malé podmnožiny „typických zástupců“ tréninkových příkladů na základě srovnání se kterou se klasifikace provádí. Tato technika by se však měla používat s jistou opatrností, protože některé základní vzory se nemusí ve vybrané podmnožině projevit.

Pokud jde o nejslavnějšího zástupce této skupiny - metodu k-nearest soused - je vhodnější pro ty obory, kde jsou atributy objektů převážně numerické, protože určení vzdálenosti mezi příklady je v tomto případě přirozenější než pro diskrétní atributy.

4.3.2. Identifikace a použití formalizovaných vzorů

Metody v této skupině extrahují běžné závislosti ze sady dat a následně je umožňují aplikovat v praxi. Liší se od sebe:

- podle typů vyhledávaných informací (které jsou určeny řešenou úlohou – viz klasifikace úloh IAD výše);

- způsobem prezentace nalezených vzorů.

Formalismus zvolený k vyjádření zákonů nám umožňuje rozlišit tři různé přístupy, z nichž každý má kořeny v odpovídajících odvětvích matematiky:

- metody křížové tabulky;

- metody logické indukce;

- metody odvozování rovnic.

Booleovské metody jsou nejuniverzálnější v tom smyslu, že mohou pracovat s numerickými i jinými typy atributů. Konstrukce rovnic vyžaduje redukci všech atributů na číselnou formu, zatímco křížová tabulka naopak vyžaduje převod každého číselného atributu na diskrétní sadu intervalů.

Metody křížové tabulky

Křížová tabulka je jednoduchá forma analýzy široce používaná v online sestavování analytického zpracování (OLAP). Dvourozměrná kontingenční tabulka je matice hodnot, jejíž každá buňka leží v průsečíku hodnot atributů. Rozšíření myšlenky křížové tabulkové reprezentace na případ hyperkubického informačního modelu je, jak již bylo zmíněno, základem multidimenzionální analýzy dat, proto lze tuto skupinu metod považovat za symbiózu vícerozměrné operační analýzy a data miningu. .

Křížová vizualizace je nejjednodušší implementací myšlenky hledání informací v datech pomocí metody křížové tabulky. Přísně vzato, tato metoda zcela nezapadá do známé vlastnosti IAD - přechod iniciativy do systému ve fázi volného vyhledávání. Ve skutečnosti je křížová vizualizace součástí funkčnosti OLAP. Zde systém poskytuje pouze matici indikátorů, ve které analytik vidí vzorec. Ale samotné poskytnutí takové křížové tabulky je zaměřeno na hledání „vzorců informací“ v datech pro podporu rozhodování, to znamená, že splňuje výše uvedenou definici IAD. Není proto náhodou, že mnozí autoři [, ,] stále řadí mezitabulkovou vizualizaci mezi metody IAD.

Metody IAD skupiny křížových tabulek také zahrnují použití Bayesových sítí, které jsou založeny na Bayesově teorému teorie pravděpodobnosti k určení zadních pravděpodobností komponent. celá skupina dvojice neslučitelných událostí podle jejich předchozích pravděpodobností:

Bayesovské sítě byly aktivně využívány k formalizaci znalostí expertů v expertních systémech, ale nedávno se začaly používat v IAD k extrakci znalostí z dat.

Po oříznutí stromu jsou jeho různé koncové uzly na různých úrovních, to znamená, že cesta k nim zahrnuje různá množství kontroly hodnot atributů; jinými slovy, abychom se dostali k terminálovým uzlům umístěným na vysokých úrovních stromu, hodnoty mnoha atributů se vůbec neberou v úvahu. Proto je při sestavování rozhodovacích stromů rozhodující pořadí, ve kterém jsou atributy testovány v rozhodovacích uzlech.

Strategie používaná v algoritmech indukce rozhodovacího stromu se nazývá strategie rozděl a panuj, na rozdíl od strategie odděluj a panuj, na které je založeno mnoho algoritmů indukce pravidel. Quinlan popsal následující algoritmus rozdělení a zachycení.

Mnoho atributů;

- mnoho možné hodnoty atribut ![]() (domény definice spojitých atributů pro konstrukci rozhodovacích stromů tedy musí být také rozděleny na konečnou množinu intervalů).

(domény definice spojitých atributů pro konstrukci rozhodovacích stromů tedy musí být také rozděleny na konečnou množinu intervalů).

Quinlan navrhl vypočítat E-skóre následovně. Nechť pro aktuální uzel:

Počet pozitivních příkladů;

- počet negativních příkladů;

- počet pozitivních příkladů s hodnotou pro ;

- počet negativních příkladů s hodnotou pro .

E-skóre je informačně-teoretická míra založená na entropii. Ukazuje míru nejistoty klasifikace, která vzniká při použití příslušného atributu v rozhodovacím uzlu. Proto je atribut s nejnižším E-skóre považován za atribut s nejvyšší klasifikační schopností. Takto definované E-skóre má však také nevýhody: zejména dává výhodu atributům s velkým počtem hodnot při konstrukci stromu. Proto některé práce [, ] navrhovaly úpravy E-odhadu, které tyto nedostatky odstraňují.

Prořezávání rozhodovacího stromu za účelem zlepšení prediktivní přesnosti při klasifikaci nových příkladů se obvykle provádí na zkonstruovaném úplném stromu, to znamená, že se provádí postup po zjednodušení. Pohybem zdola nahoru jsou rozhodovací uzly s odpovídajícími podstromy nahrazeny koncovými uzly, dokud není daná heuristická míra optimalizována.

Indukce pravidla

Popularita rozhodovacích stromů pramení z jejich rychlosti výstavby a snadného použití při klasifikaci. Rozhodovací stromy lze navíc snadno převést na sady symbolických pravidel generováním jednoho pravidla z každé cesty od kořene k koncovému uzlu. Pravidla v takové sadě se však nebudou překrývat, protože v rozhodovacím stromu lze každý příklad přiřadit pouze jednomu koncovému uzlu. Obecnější (a realističtější) je případ existence teorie sestávající ze souboru nehierarchických překrývajících se symbolických pravidel. Významná část algoritmů, které provádějí indukci takových souborů pravidel, je kombinována se strategií separace a zachycení (separate-and-conquer) nebo covering (covering), která začala prací R. Michalského [,] . Termín „separace a zachycení“ formulovali Pagallo a Haussler, kteří tuto indukční strategii charakterizovali takto:

- vytvořit pravidlo pokrývající část tréninkového souboru;

- odstranit příklady, na které se vztahuje pravidlo, ze sady školení (oddělení);

- postupně se učit další pravidla týkající se skupin zbývajících příkladů (zachycení), dokud nebudou všechny příklady vysvětleny.

Rýže. 5 ukazuje obecný algoritmus pro indukci pravidel metodou separace a zachycení. Různé možnosti implementace pro podprogramy volané v obecném algoritmu určují různé známé metody separace a zachycení.

Rýže. 5. Obecný separační a zachytávací algoritmus pro indukci pravidel.

Algoritmus SEPARATEANDCONQUER začíná prázdnou teorií. Pokud jsou v trénovací sadě pozitivní příklady, zavolá se podprogram FINDBESTRULE, aby extrahoval pravidlo, které pokrývá část pozitivních příkladů. Všechny probrané příklady se pak oddělí od trénovací sady, výsledné pravidlo se zahrne do teorie a ze zbývajících příkladů se hledá další pravidlo. Pravidla se načítají, dokud nezůstanou žádné kladné příklady nebo dokud není splněno kritérium zastavení RULESTOPPINGCRITERION. Často je výsledná teorie podrobena následnému zpracování POSTPROCESSEM.

Procedura FINDBESTRULE hledá v prostoru hypotéz pravidlo, které optimalizuje zvolené kritérium kvality popsané v EVALUATERULE. Hodnota této heuristické funkce je zpravidla tím vyšší, čím více pozitivních a méně negativních příkladů zahrnuje kandidátské pravidlo. FINDBESTRULE zpracovává Pravidla, uspořádaný seznam kandidátských pravidel generovaný procedurou INITIALIZERULE.

Nová pravidla jsou vždy vložena do správná místa(INSERTSORT), takže Pravidla vždy zůstanou seznamem seřazeným v sestupném pořadí podle heuristických vyhodnocení pravidel. V každé smyčce vybere SELECTCANDIDATES podmnožinu kandidátských pravidel, která se pak vymaže v REFINERULE. Každý výsledek čištění je vyhodnocen a vložen do seřazeného seznamu pravidel, pokud tomu nezabrání STOPPINGCRITERION. Pokud je skóre NewRule lepší než nejlepší dříve nalezené pravidlo, hodnota NewRule se přiřadí proměnné BestRule. FILTERRULES vybere podmnožinu uspořádaného seznamu pravidel pro použití v dalších iteracích. Po zpracování všech kandidátských pravidel se vrátí nejlepší pravidlo.

Hlavním problémem, kterému čelí algoritmy indukce pravidel, zůstává vyhnout se nadměrnému přizpůsobení při použití zašuměných dat. Přehnané vyhýbání se v algoritmech pro odpojení a zachycení zvládne hluk:

Porovnání schopností rozhodovacích stromů a indukce pravidel

Indukční a rozhodovací stromy, které jsou způsoby řešení stejného problému, se výrazně liší svými schopnostmi. Navzdory rozšířenému používání rozhodovacích stromů se z řady důvodů uvedených v [ , , ] jeví indukce pravidel jako výhodnější přístup.

Na druhé straně je indukce pravidel prováděna mnohem složitějšími (a pomalejšími) algoritmy než indukce rozhodovacího stromu. Obzvláště velké potíže vznikají s post-zjednodušením konstruované teorie, na rozdíl od jednoduchosti prořezávání rozhodovacích stromů, na kterou upozornil Furnkranz: prořezávání větví v rozhodovacím stromě nikdy neovlivní sousední větve, zatímco prořezávání podmínek pravidla ovlivní všechny pravidla, která se s ním překrývají (obr. 6).

Rýže. 6. Přijetí do učebních algoritmů

a) oddělení a odchyt ab) oddělení a odchyt.

Rýže. 6(a) ilustruje práci post-zjednodušení při indukci rozhodovacích stromů. Pravá polovina překomplikovaného stromu je pokryta sadami C a D tréninkových příkladů. Když se zjednodušující algoritmus rozhodne ořezat tyto dva terminální vrcholy, uzel, který je vytvořil, se stane terminálním uzlem, který je nyní popsán v příkladech. Levá větev rozhodovací strom není touto operací ovlivněn.

Na druhou stranu odříznutí podmínek od pravidla znamená jeho zobecnění, tedy v nové podobě pokryje více pozitivních a více negativních příkladů. V důsledku toho musí být tyto další pozitivní a negativní příklady vyloučeny ze sady školení, aby neovlivnily zavedení následných pravidel. V případě na Obr. 6(b) první ze tří pravidel zjednodušuje a začíná pokrývat nejen příklady zahrnuté v původní verzi, ale také všechny příklady, které pokrývá třetí pravidlo, a také některé příklady, které pokrývá druhé pravidlo. Pokud lze třetí pravidlo jednoduše odstranit pomocí post-zjednodušovacího algoritmu, pak situace se zbývající sadou příkladů B2 není tak jednoduchá. Druhé pravidlo přirozeně pokrývá všechny příklady množiny B2, protože bylo vytvořeno tak, aby pokrylo příklady množiny B, která jej obsahuje. Může se však stát, že pro oddělení kladných příkladů B2 od množiny bude vhodnější jiné pravidlo zbývající negativní příklady. Správné zpracování takových situací vyžaduje úzkou integraci procesů před zjednodušením a po zjednodušení, což výrazně komplikuje algoritmus indukce pravidel a zhoršuje jeho výkon.

Na základě srovnání tedy můžeme usoudit, že konstrukce rozhodovacích stromů má své opodstatnění v jednoduchých problémech s malým množstvím výchozích informací díky jednoduchosti a rychlosti jejich indukce. Nicméně při analýze velké objemy dat nashromážděných v úložištích je přes jejich relativní složitost vhodnější použití metod indukce pravidel.

Metody odvozování rovnic

Metody odvozování rovnic se pokoušejí vyjádřit vzory skryté v datech ve formě matematických výrazů. Jsou tedy schopny pracovat pouze s atributy číselného typu, zatímco ostatní atributy je nutné uměle zakódovat číselnými hodnotami. To vyvolává několik problémů, které omezují použití těchto metod v praxi. Jsou však široce používány v mnoha aplikacích.

Statistika

Klasické metody statistické analýzy se v nástrojích IAD používají nejčastěji k řešení prognostického problému.

- Identifikace trendů v časových řadách. Trend průměrné úrovně lze prezentovat ve formě grafu nebo analytické funkce, kolem jejíž hodnoty se skutečné hodnoty úrovní zkoumaného procesu mění. Trendy na průměrné úrovni se často nazývají deterministickou složkou procesu a odpovídající časová řada je vyjádřena rovnicí

, kde je úroveň řady v čase t, je deterministická složka řady, je náhodná složka. Deterministická složka je obvykle reprezentována poměrně jednoduchou analytickou funkcí - lineární, parabolická, hyperbolická, exponenciální - jejíž parametry jsou vybírány podle historických dat pro lepší aproximaci historických dat.

, kde je úroveň řady v čase t, je deterministická složka řady, je náhodná složka. Deterministická složka je obvykle reprezentována poměrně jednoduchou analytickou funkcí - lineární, parabolická, hyperbolická, exponenciální - jejíž parametry jsou vybírány podle historických dat pro lepší aproximaci historických dat. - Harmonická analýza. V mnoha případech vyhlazování časových řad pomocí stanovení trendu nedává uspokojivé výsledky, protože u reziduí je pozorována autokorelace. Důvodem autokorelace reziduí mohou být znatelné periodické výkyvy, které se často vyskytují v dynamických řadách vzhledem k identifikovanému trendu. V takových případech bychom se měli uchýlit k harmonické analýze, to znamená k izolaci periodické složky od dynamické řady. Na základě výsledků izolace trendu a periodické složky z časové řady lze provést statistickou předpověď procesu na principu extrapolace za předpokladu, že parametry trendu a kolísání zůstanou pro prognózu stejné. období [, str. 304].

- Korelační a regresní analýza. Na rozdíl od funkčního (přísně stanoveného) spojení dochází ke statistickému (stochasticky deterministickému) spojení mezi proměnnými, když se změnou hodnoty jedné z nich může druhá v určitých mezích nabývat jakékoli hodnoty s určitou pravděpodobností, ale jeho průměrná hodnota nebo jiné statistické charakteristiky se mění podle určitého zákona [, s. 191-192]. Speciálním případem statistického vztahu, kdy různé hodnoty jedné proměnné odpovídají různým průměrným hodnotám jiné, je korelační vztah. V souladu s podstatou korelace má její studium dva cíle:

1) měření parametrů rovnice vyjadřující vztah mezi průměrnými hodnotami závislých proměnných a hodnotami nezávisle proměnné (závislost průměrných hodnot výsledné charakteristiky na hodnotách charakteristiky faktorů);

2) měření těsnosti souvislosti mezi rysy [, s. 195-196].

Metoda korelačně-regresní analýzy byla dobře prostudována [, 19, 29] a je široce používána v praxi. Má však řadu omezení:

1) pro zajištění dostatečné přesnosti a spolehlivosti musí být počet pozorování desítky nebo stokrát větší než počet faktorů, aby zákon velkých čísel, fungující v plné síle, zajistil účinné vzájemné zrušení náhodných odchylek od přirozeného povaha vztahu znaků;

2) pro spolehlivé vyjádření vzoru na základě průměrné hodnoty je potřeba dostatečně kvalitní homogenita populace, aby nedocházelo ke zkreslení korelačních parametrů; Někdy je navíc jako podmínka pro korelační analýzu nutné podřídit rozdělení populace podle výsledných a faktorových charakteristik normálnímu zákonu rozdělení pravděpodobnosti (tato podmínka je spojena s použitím metody nejmenších čtverců při výpočtu korelačních parametrů - pouze s normálním rozdělením dává odhad parametrů splňující principy maximální věrohodnosti, i když v praxi i při přibližném splnění tohoto předpokladu dává metoda nejmenších čtverců dobré výsledky [, P. 14];

3) metoda korelační-regresní analýzy nemůže vysvětlit roli faktorových charakteristik při vytváření efektivní charakteristiky [, S. 198];

4) korelační ukazatele by měly být interpretovány pouze z hlediska odchylek ve výsledných a faktorových charakteristikách; pokud je úkolem měřit vztah mezi změnami charakteristik objektu v čase, pak metoda korelační-regresní analýzy vyžaduje významné změny (je nutná studie korelace časových řad) [ ; , str. 307-313].

Výsledné korelačně-regresní modely (CRM) jsou obvykle docela dobře interpretovatelné a lze je použít v prediktivním modelování. Ale jak je uvedeno v, je nemožné použít tento typ analýzy bez hlubokých znalostí v oblasti statistiky. Zvláště důležitou roli zde hraje teoretická příprava analytika, takže málokdo stávající zařízení IAD nabízejí metodu korelační-regresní analýzy jako jeden z nástrojů zpracování dat. - Korelace časových řad. Problém studia kauzálních vztahů v čase je velmi složitý a kompletní řešení všech problémů takového studia dosud nebylo vyvinuto [, S. 307]. Hlavním problémem je, že pokud existuje trend po dostatečně dlouhé časové období, většina součtu čtverců odchylek je spojena s trendem; Navíc, pokud mají dvě charakteristiky trendy se stejným směrem změny úrovní, pak to vůbec nebude znamenat kauzální vztah. Pro získání skutečných korelačních ukazatelů je tedy nutné abstrahovat od zkreslujícího vlivu trendů – vypočítat odchylky od trendů a měřit korelaci fluktuací (podrobnému zvážení tohoto přístupu je věnována celá práce). Ne vždy je však přípustné přenášet závěry o úzké souvislosti mezi fluktuacemi na souvislost mezi dynamickými řadami jako celkem (podle příkladu uvedeného v [, S. 312] je legitimní uvažovat o souvislosti mezi fluktuacemi v výnos a kolísání množství srážek, které spadlo přes léto, ale souvislost mezi užitkovostí a dávkou hnojiv nelze redukovat pouze na korelaci kolísání).

Neuronové sítě

Umělé neuronové sítě jako prostředek zpracování informací byly modelovány analogicky se známými principy fungování biologických neuronové sítě. Jejich struktura je založena na následujících předpokladech [, S. 3]:

- zpracování informací se provádí v mnoha jednoduchých prvcích - neuronech;

- signály mezi neurony jsou přenášeny prostřednictvím spojení z výstupů na vstupy;

- každé spojení je charakterizováno váhou, kterou se násobí signál přes něj přenášený;

- každý neuron má aktivační funkci (obvykle nelineární), jejíž argument se vypočítá jako součet vážených vstupních signálů a výsledek je považován za výstupní signál.

Neuronové sítě jsou tedy množiny propojených uzlů, z nichž každý má vstup, výstup a aktivační funkci (obvykle nelineární) (obr. 7). Mají schopnost učit se ze známé sady příkladů v tréninkové sadě. Trénovaná neuronová síť je „černá skříňka“ (neinterpretovatelný nebo velmi obtížně interpretovatelný prediktivní model), kterou lze použít při klasifikaci, shlukování a předpovídání problémů.

Rýže. 7. Neuron s aktivační funkcí F; ![]() .

.

Trénink neuronové sítě zahrnuje úpravu váhových koeficientů, které spojují výstupy některých neuronů se vstupy jiných. Školení sítě lze provést pomocí jednoho ze dvou základních scénářů:

Nejčastěji se používají agenti IAD speciální typ neuronové sítě trénované „s učitelem“ – vícevrstvé perceptrony [, s. 54-55]. Na Obr. Obrázek 8 ukazuje takovou neuronovou síť se dvěma vrstvami neuronů, která má tři vstupní a tři výstupní proměnné (obecně může být počet vstupů, počet výstupů, počet vrstev a počet neuronů v každé vnitřní vrstvě jakýkoli ). Výstup každého neuronu předchozí vrstvy je spojen se vstupem každého neuronu následující vrstvy.

Rýže. 8. Vícevrstvý perceptron trénovaný postupem zpětné šíření chyby.

Úprava vah vícevrstvého perceptronu se provádí pomocí algoritmu zpětného šíření chyb [, s. 56-69]. Při trénování se předpokládá, že pro každý vstupní vektor (množinu vstupů) je s ním spárován cílový vektor (množina výstupů) a společně tvoří trénovací dvojici (příklad). Před začátkem tréninku by měly být všem vahám přiřazeny malé počáteční hodnoty, vybrané náhodně, aby se zabránilo patologickým případům selhání učení. Celá sada tréninkových dvojic tvoří tréninkovou sadu. Školení sítě vyžaduje následující operace:

- vyberte tréninkovou dvojici z tréninkové sady;

- předložit vstupní vektor trénovacího páru na síťový vstup;

- vypočítat výkon sítě;

- vypočítat rozdíl mezi síťovým výstupem a cílovým vektorem trénovacího páru;

- upravit váhy sítě pro minimalizaci chyb;

- opakujte kroky 1-5 pro každý pár tréninkové sady, dokud chyba na celé sestavě nedosáhne přijatelné úrovně.

Trénink pomocí metody backpropagation se provádí vrstvu po vrstvě, počínaje výstupní vrstvou, v krocích 4 a 5.

Jako „univerzální aproximátory“ se perceptrony mohou naučit poměrně složité vzorce, na rozdíl od regresních modelů, ve kterých je typ aproximační funkce vybrán z omezené možné množiny. Tato flexibilita má ale i stinnou stránku – počet stupňů volnosti vytvořeného prediktivního modelu často převyšuje počet příkladů použitých pro trénink. To znamená, že neuronová síť se může „učit“ i z řady generovaných náhodná čísla. Jak ukazuje použití neuronové sítě k řešení testovacího problému analýzy akciového trhu uvedeného v ukázkách, dokonale vysvětluje všechny výkyvy trhu v minulosti, ale neposkytuje přiměřenou předpověď pro budoucnost. Zlepšení prediktivní přesnosti trénované sítě lze dosáhnout použitím pouze určité části trénovací množiny pro trénování neuronové sítě, zatímco zbývající část příkladů slouží k testování přiměřenosti vytvořeného modelu na neznámých datech; Zároveň byste se měli pokusit trénovat síť s co nejméně složitou konfigurací, abyste snížili počet stupňů volnosti.

Existuje řada dalších nevýhod, které omezují použití neuronových sítí jako nástroje IAD.

Hlavním problémem trénování neuronových sítí je syntéza síťové struktury schopné učení na dané trénovací množině. Neexistuje žádná záruka, že proces trénování sítě určité struktury se nezastaví před dosažením přijatelného prahu chyb nebo neklesne do lokálního minima. Ačkoli jsou vícevrstvé sítě široce používány pro klasifikaci funkcí a aproximaci, jejich strukturální parametry je stále třeba určit metodou pokusu a omylu. Podle závěrů dosavadní teoretické výsledky poskytují pouze slabé vodítko pro výběr těchto parametrů v praktických aplikacích.

Neuronové sítě, poměrně výkonný a flexibilní nástroj IDA, by tedy měly být používány s určitou opatrností a nejsou vhodné pro všechny problémy, které vyžadují těžbu podnikových dat.

4.3.3. Závěry

Jak je z přehledu patrné, žádná z uvažovaných metod není schopna pokrýt všechny úkoly, které poskytují podporu pro manažerská rozhodnutí založená na dolování obsahu datových skladů. Většina stávajících inteligentních analytických systémů na trhu však implementuje jednu nebo tři metody (například Pilot Discovery Server od společnosti Pilot Software Inc. a Information Harvester od společnosti Information Harvester Corp. - pouze rozhodovací stromy, Idis od společnosti Information Discovery Inc. - rozhodovací stromy a indukce pravidel, Darwin od Thinking Machines - neuronové sítě, rozhodovací stromy a vizualizace dat, MineSet od Silicon Graphics - rozhodovací stromy, indukce asociativních pravidel a vizualizace dat), proto v skutečné aplikace Aby nedošlo ke ztrátě velkého množství významných vzorů, je zpravidla nutné použít několik různých nástrojů. Řada nástrojů navíc neumožňuje přímou práci s datovými sklady, což vyžaduje předběžnou přípravu zdrojových dat pro analýzu ve formě plochých souborů pevné struktury, což také komplikuje jejich praktické použití.

5. Komplementarita OLAP a IAD

Operační analytické zpracování a dolování dat jsou dvě součásti procesu podpory rozhodování. Dnes se však většina systémů OLAP zaměřuje pouze na poskytování přístupu k vícerozměrným datům a většina nástrojů pro analýzu vzorů se zabývá perspektivami jednorozměrných dat. Tyto dva typy analýz musí být úzce kombinovány, to znamená, že systémy OLAP se musí soustředit nejen na přístup, ale také na hledání vzorců.

Rýže. 9. Architektura multidimenzionálního systému pro dolování dat.

Ideálním cílem budování podnikového informačního a analytického systému je vytvoření DSS s uzavřeným cyklem. Jak poznamenal N. Raden, „mnoho společností vytvořilo... vynikající datové sklady, ideálně třídící do regálů hory nevyužitých informací, což samo o sobě neposkytuje ani rychlou, ani dostatečně kompetentní reakci na dění na trhu“ [, s. 39] . Ve zvláště dynamických oblastech (například v maloobchodě), kde se situace denně mění, není zajištěno včasné kompetentní rozhodování ani při použití konvenčních nástrojů OLAP a IAD. Musí být vzájemně integrovány a mít zpětnou vazbu do systémů zpracování zdrojových dat, aby výsledky DSS byly okamžitě předávány formou kontrolních akcí do provozních systémů. Největší americká maloobchodní společnost Wal-Mart tedy vyvíjí DSS s uzavřeným cyklem)